Проекционная матрица: от уничтожения до «Мамбы»

Автор: Josef Albers

Загружено: 2026-01-12

Просмотров: 8

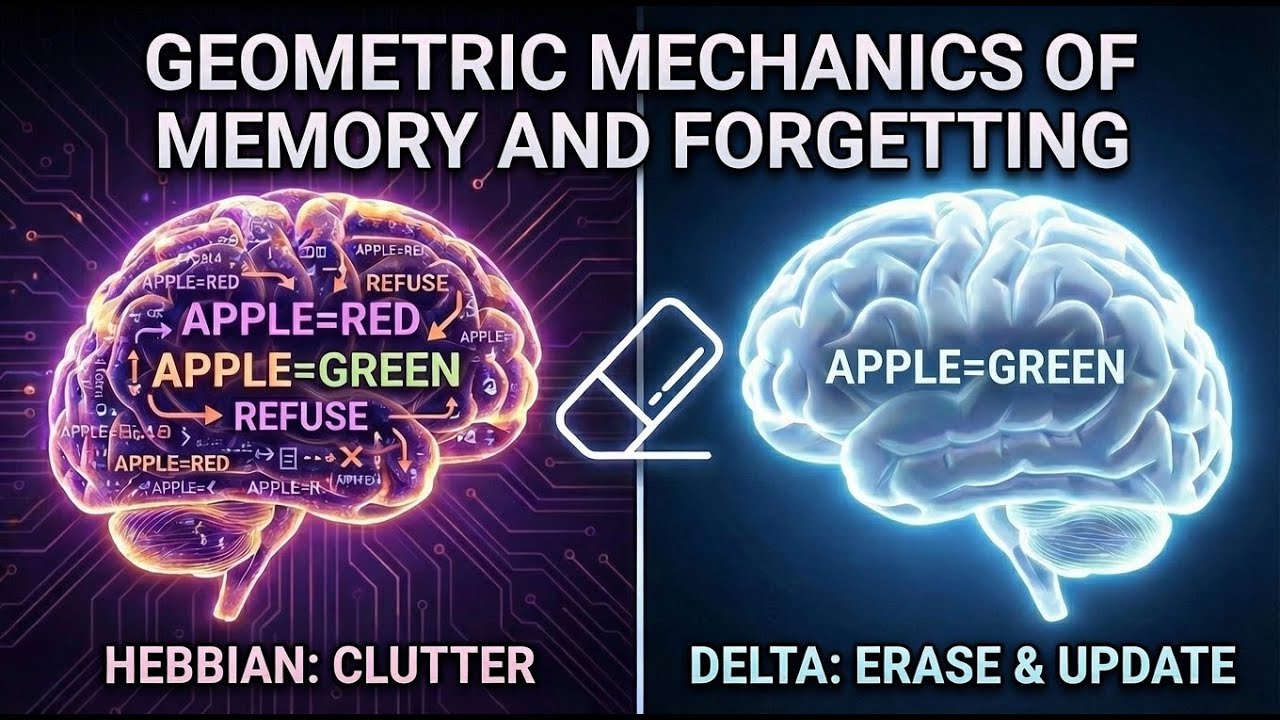

В этом видео рассматривается геометрическая механика памяти и забывания в современных моделях искусственного интеллекта, где, казалось бы, разные концепции, такие как линейное внимание, DeltaNet и удаление модели, объединяются путем демонстрации того, что все они основаны на одних и тех же примитивах линейной алгебры. В частности, в этом видео показано, как проекционные матрицы используются в качестве «ластиков» для точечного удаления нежелательных действий, таких как «отказ» в методах удаления, или для перезаписи устаревшей информации в линейных рекуррентных нейронных сетях. Манипулируя внешними произведениями и ковариационными структурами, исследователи могут точно контролировать, накапливает ли модель новые знания или удаляет определенные направления данных. Этот подход переосмысливает безопасность и архитектуру ИИ как общую задачу управления многомерными векторными пространствами. В конечном итоге, обучение представляет собой сложение посредством хеббианских ассоциаций, в то время как избирательное забывание — это проекция посредством ортогонализации весов.

Проекция: Pv = (rrᵀ)v = r(rᵀv) = r•(скалярное скалярное произведение)

Геббиан: Sᵢ = S₍i-1₎ + vᵢkᵢᵀ

Дельта: Sᵢ = S₍i-1₎ - β(S₍i-1₎kᵢ - vᵢ)kᵢᵀ = S₍i-1₎(I - βkᵢkᵢᵀ) + βvᵢkᵢᵀ

Аблитерация: (rrᵀ•W)x = rrᵀ(Wx)

Оригинальный пост в блоге: https://github.com/JosefAlbers/blog/blob/m...

Доступные форматы для скачивания:

Скачать видео mp4

-

Информация по загрузке: