[Open DMQA Seminar] Plasticity in Deep Reinforcement Learning

Автор: 김성범[ 교수 / 산업경영공학부 ]

Загружено: 2025-06-25

Просмотров: 560

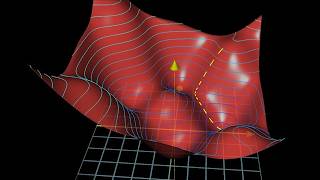

신경망은 비정상(non-stationary)한 목표를 학습한 후 새로운 과제에 적응하는 능력, 즉 가소성(plasticity)이 저하되는 현상을 보인다. 이는 특히 입력과 출력 간의 관계가 변화하고, 이전 예측을 덮어써야 하는 강화학습에서 두드러지게 나타난다. 이로 인해 에이전트는 새로운 환경에 빠르게 적응하지 못하고, 학습 효율이 저하되는 문제가 발생한다. 심층강화학습에서는 이러한 plasticity 문제가 빈번하게 발생하며, 본 세미나에서는 이를 개선하기 위한 방법론들을 소개한다.

참고자료:

[1] Lyle, C., Zheng, Z., Nikishin, E., Pires, B. A., Pascanu, R., & Dabney, W. (2023, July). Understanding plasticity in neural networks. In International Conference on Machine Learning (pp. 23190-23211). PMLR.

[2] Nikishin, E., Schwarzer, M., D’Oro, P., Bacon, P. L., & Courville, A. (2022, June). The primacy bias in deep reinforcement learning. In International conference on machine learning (pp. 16828-16847). PMLR.

[3] Sokar, G., Agarwal, R., Castro, P. S., & Evci, U. (2023, July). The dormant neuron phenomenon in deep reinforcement learning. In International Conference on Machine Learning (pp. 32145-32168). PMLR.

[4] Nikishin, E., Oh, J., Ostrovski, G., Lyle, C., Pascanu, R., Dabney, W., & Barreto, A. (2023). Deep reinforcement learning with plasticity injection. Advances in Neural Information Processing Systems, 36, 37142-37159.

![[Open DMQA Seminar] Plasticity in Deep Reinforcement Learning](https://ricktube.ru/thumbnail/J7D3M2_JCqo/hq720.jpg)

Доступные форматы для скачивания:

Скачать видео mp4

-

Информация по загрузке:

![[Open DMQA Seminar] Vision Language Models](https://ricktube.ru/thumbnail/3mczoeHo7zw/mqdefault.jpg)