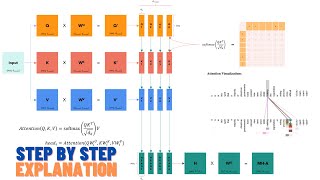

Adding vs. concatenating positional embeddings & Learned positional encodings

Автор: AI Coffee Break with Letitia

Загружено: 2021-07-18

Просмотров: 24981

When to add and when to concatenate positional embeddings? What are arguments for learning positional encodings? When to hand-craft them? Ms. Coffee Bean’s answers these questions in this video.

➡️ AI Coffee Break Merch! 🛍️ https://aicoffeebreak.creator-spring....

Outline:

00:00 Concatenated vs. added positional embeddings

04:49 Learned positional embeddings

06:48 Ms. Coffee Bean deepest insight ever

▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀

🔥 Optionally, help us boost our Coffee Bean production! ☕

Patreon: / aicoffeebreak

Ko-fi: https://ko-fi.com/aicoffeebreak

▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀▀

📺 Positional embeddings explained: • Positional embeddings in transformers EXPL...

📺 Fourier Transform instead of attention: • FNet: Mixing Tokens with Fourier Transform...

📺 Transformer explained: • The Transformer neural network architectur...

Papers 📄:

Vaswani, Ashish, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N. Gomez, Łukasz Kaiser, and Illia Polosukhin. "Attention is all you need." In Advances in neural information processing systems, pp. 5998-6008. 2017. https://proceedings.neurips.cc/paper/...

Wang, Yu-An, and Yun-Nung Chen. "What do position embeddings learn? an empirical study of pre-trained language model positional encoding." arXiv preprint arXiv:2010.04903 (2020). https://arxiv.org/pdf/2010.04903.pdf

Dosovitskiy, Alexey, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani et al. "An image is worth 16x16 words: Transformers for image recognition at scale." arXiv preprint arXiv:2010.11929 (2020). https://arxiv.org/abs/2010.11929

✍️ Arabic Subtitles by Ali Haidar Ahmad / ali-ahmad-0706a51bb .

🔗 Links:

AICoffeeBreakQuiz: / aicoffeebreak

Twitter: / aicoffeebreak

Reddit: / aicoffeebreak

YouTube: / aicoffeebreak

#AICoffeeBreak #MsCoffeeBean #MachineLearning #AI #research

Доступные форматы для скачивания:

Скачать видео mp4

-

Информация по загрузке:

![Как внимание стало настолько эффективным [GQA/MLA/DSA]](https://ricktube.ru/thumbnail/Y-o545eYjXM/mqdefault.jpg)