#4 ЖЁСТКОЕ NLP Собеседовние Middle+ / Senior Data Scientist 2 часть| RNN self-attention transformers

Автор: Dima Savelko

Загружено: 14 апр. 2025 г.

Просмотров: 2 178 просмотров

Доведение с нуля до ОФФЕРА 💸 - https://ds-mentor.ru/

🔎 NLP секция - неотъемлемая часть получения оффера для NLP инженера. Как раз таки в этом видео я даю базу, которую спрашивают на подобных собеседованиях и объясняю на пальцах эти темы так, чтобы ты точно на них ответил.

📊 Разбираем:

RNN , плюсы и минусы , сложность RNN

Transformers , полное устройство self-attention внутри

Различия между RNN и transformers

Токенайзеры , виды, и как они работают

Написали Self-Attention с нуля на Torch

💡 Проверь свои знания и подготовься к собеседованию!

Привет!

Я Дима Савелко - Ментор и Deep Learning Engineer (ClassicML, NLP/LLM) с 4-летним опытом коммерческой разработки как на СНГ сегменте, так и на зарубежном рынке. Параллельно официальной работе руковожу AI-командой для реализации проектов, решая задачи бизнеса с помощью ИИ. Также обо мне вы можете почитать в моём телеграм-канале!

Ссылки:

Менторство: https://ds-mentor.ru/

tg: https://t.me/ngmdite

tg-channel: https://t.me/eboutdatascience

Видео Котенкова про трансофрмеры - • Transformer, explained in detail | Ig...

Таймкоды:

00:00 Что такое....?

00:20 Приветствие

01:15 Что такое RNN?

02:08 Объяснение - что такое RNN и как он работает

05:39 Какие есть плюс и минусы у RNN ?

07:30 Объяснение минусов и плюсов RNN

08:31 Какая сложность у RNN ?

08:39 Выводим с нуля сложность RNN

16:20 Что такое transformers (трансформеры)? Чем они отличаются от RNN ?

17:20 С нуля до ОФФЕРА

18:25 Почему у RNN и у transformers эмбеддинги называются контекстуальными ?

19:28 Объяснение - что такое контекстуальные эмбеддинги ?

21:03 Нужно ли в transformers использовать предобработку текста ?

21:48 Что такое токенайзер ? Какие виды существуют ?

22:29 Объяснение - Что такое токенайзер ? Какие виды существуют ?

28:01 Можно ли расширять токенайзер ? И в каких случаях это стоит делать?

28:28 Объяснение - Можно ли расширять токенайзер ? И в каких случаях это стоит делать?

29:49 Зачем нужна матрица эмбеддингов в transformers? И как её обучать с нуля ?

30:17 Объяснение - Зачем нужна матрица эмбеддингов в transformers? И как её обучать с нуля ?

33:57 Чем обычные токены отличаются от специализированных ?

34:57 На что влияет размер словаря в transformers ?

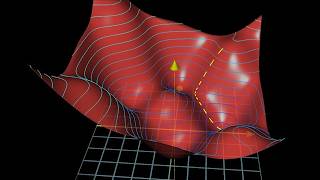

37:17 Что такое self-attention в transformers ?

38:02 Объяснение - Что такое self-attention в transformers ?

44:07 Ещё больше вопросов с собесов тут - телеграм канал

44:14 Какая архитектура у self-attention ? Как он устроен внутри ?

44:43 Подробнейшее объяснение устройства self-attention

57:51 Написание self-attention с нуля на torch

01:03:26 Концовка и жёстка навалил фонка в конце

Доступные форматы для скачивания:

Скачать видео mp4

-

Информация по загрузке: