Что такое метод наименьших квадратов?

Автор: AlphaOpt

Загружено: 2022-04-17

Просмотров: 139533

Краткое введение в метод наименьших квадратов — метод подгонки модели, кривой или функции к набору данных.

РАСШИФРОВКА

Здравствуйте и добро пожаловать на курс «Введение в оптимизацию». В этом видео даётся простой ответ на вопрос: что такое метод наименьших квадратов?

Метод наименьших квадратов — это метод подгонки уравнения, линии, кривой, функции или модели к набору данных. Этот простой метод применяется во многих областях: от медицины и финансов до химии и астрономии. МНК помогает нам представлять реальный мир с помощью математических моделей.

Давайте подробнее рассмотрим, как это работает. Представьте, что у вас есть набор точек данных x и y, и вы хотите найти линию, которая наилучшим образом соответствует этим данным. Это также называется регрессией. Для заданного x у вас есть значение y из ваших данных и значение y, предсказанное линией. Разница между этими значениями называется ошибкой или невязкой.

Невязка рассчитывается между каждой точкой данных и линией. Чтобы получить только положительные значения ошибки, ошибка обычно возводится в квадрат. Затем отдельные остатки суммируются, чтобы получить общую ошибку между данными и прямой – сумму квадратов ошибок.

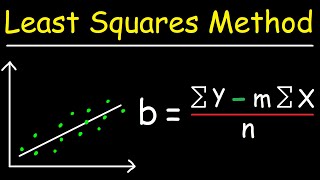

МНК можно рассматривать как задачу оптимизации. Сумма квадратов ошибок – это целевая функция, а оптимизатор пытается найти наклон и точку пересечения прямой с осью, которые наилучшим образом минимизируют ошибку.

Здесь мы пытаемся подобрать прямую, что делает эту задачу линейной МНК. Линейная МНК имеет решение в замкнутой форме и может быть решена путем решения системы линейных уравнений. Стоит отметить, что другие уравнения, такие как параболы и многочлены, также могут быть подогнаны с помощью линейного МНК, при условии, что оптимизируемые переменные линейны.

МНК также можно использовать для нелинейных кривых и функций для подгонки более сложных данных. В этом случае задачу можно решить с помощью специализированного решателя нелинейной МНК или универсального решателя оптимизации.

Подводя итог, можно сказать, что метод наименьших квадратов часто используется для подгонки модели к данным. Остатки выражают погрешность между текущей подгонкой модели и данными. Цель метода наименьших квадратов — минимизировать сумму квадратов погрешностей по всем точкам данных, чтобы найти наилучшее соответствие для данной модели.

Доступные форматы для скачивания:

Скачать видео mp4

-

Информация по загрузке:

![Суть линейной алгебры: #1. Векторы [3Blue1Brown]](https://ricktube.ru/thumbnail/cJslkj9_wyg/mqdefault.jpg)