Longformer: The Long-Document Transformer

Автор: Yannic Kilcher

Загружено: 2020-04-20

Просмотров: 25784

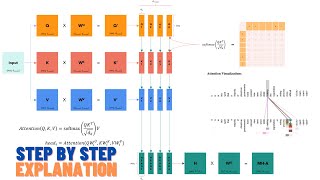

The Longformer extends the Transformer by introducing sliding window attention and sparse global attention. This allows for the processing of much longer documents than classic models like BERT.

Paper: https://arxiv.org/abs/2004.05150

Code: https://github.com/allenai/longformer

Abstract:

Transformer-based models are unable to process long sequences due to their self-attention operation, which scales quadratically with the sequence length. To address this limitation, we introduce the Longformer with an attention mechanism that scales linearly with sequence length, making it easy to process documents of thousands of tokens or longer. Longformer's attention mechanism is a drop-in replacement for the standard self-attention and combines a local windowed attention with a task motivated global attention. Following prior work on long-sequence transformers, we evaluate Longformer on character-level language modeling and achieve state-of-the-art results on text8 and enwik8. In contrast to most prior work, we also pretrain Longformer and finetune it on a variety of downstream tasks. Our pretrained Longformer consistently outperforms RoBERTa on long document tasks and sets new state-of-the-art results on WikiHop and TriviaQA.

Authors: Iz Beltagy, Matthew E. Peters, Arman Cohan

Links:

YouTube: / yannickilcher

Twitter: / ykilcher

BitChute: https://www.bitchute.com/channel/yann...

Minds: https://www.minds.com/ykilcher

Доступные форматы для скачивания:

Скачать видео mp4

-

Информация по загрузке:

![Момент, когда мы перестали понимать ИИ [AlexNet]](https://ricktube.ru/thumbnail/UZDiGooFs54/mqdefault.jpg)