Мини-пакетный градиентный спуск | Глубокое обучение | со стохастическим градиентным спуском

Автор: Learn With Jay

Загружено: 2021-08-10

Просмотров: 25460

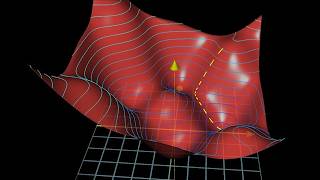

Мини-пакетный градиентный спуск — это алгоритм, который помогает ускорить обучение при работе с большими наборами данных.

Вместо обновления весовых параметров после оценки всего набора данных, мини-пакетный градиентный спуск обновляет весовые параметры после оценки небольшой части набора данных. Таким образом, мы можем добиться значительного прогресса до того, как наша модель обработает весь набор данных. Таким образом, обучение может быть очень быстрым.

В видео мы также видели стохастический градиентный спуск, который обновляет весовой параметр после оценки каждой точки или записи данных. Стохастический градиентный спуск также имеет свои недостатки, которые преодолеваются мини-пакетным градиентным спуском.

Таким образом, на практике мы не используем стохастический градиентный спуск, а мини-пакетный градиентный спуск при работе с большими наборами данных. А при работе с небольшими наборами данных мы используем простой пакетный градиентный спуск.

➖➖➖➖➖➖➖➖➖➖➖➖➖➖➖➖

✔ Плейлист «Улучшение нейронных сетей»: • Overfitting and Underfitting in Machine Le...

➖➖➖➖➖➖➖➖➖➖➖➖➖➖➖➖

✔ Полный плейлист «Нейронные сети»: • Neural Network python from scratch | Multi...

✔ Полный плейлист «Логистическая регрессия»: • Logistic Regression Machine Learning Examp...

✔ Полный плейлист по линейной регрессии: • How Neural Networks work in Machine Learni...

➖➖➖➖➖➖➖➖➖➖➖➖➖➖➖➖

Временная метка:

0:00 Повестка дня

0:38 Когда градиентный спуск не сработает

2:24 Мини-пакетный градиентный спуск в глубоком обучении

3:31 Недостатки мини-пакетного градиентного спуска

5:47 Стохастический Градиентный спуск

6:30 Когда использовать мини-пакетный градиентный спуск

➖➖➖➖➖➖➖➖➖➖➖➖➖➖➖➖

Это ваш путь к машинному обучению ⭐

➖➖➖➖➖➖➖➖➖➖➖➖➖➖➖➖➖

Подпишитесь на мой канал, ведь я каждую неделю публикую новое видео о машинном обучении: / @machinelearningwithjay

Доступные форматы для скачивания:

Скачать видео mp4

-

Информация по загрузке: