Transformer - Attention Is All You Need 논문 - LLM 기초 (Notebook LM 으로 제작)

Автор: AI 탐구생활

Загружено: 2025-10-22

Просмотров: 573

Attention Is All You Need 논문 Notebook LM 으로 생성한 동영상 개요

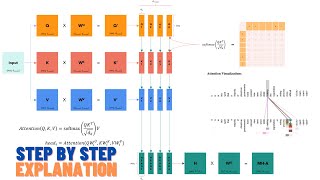

본 출처는 자연어 처리에서 지배적인 반복적 신경망(recurrent neural networks, RNN) 또는 합성곱 신경망(convolutional neural networks) 대신 어텐션 메커니즘만을 기반으로 하는 새로운 네트워크 아키텍처인 **트랜스포머(Transformer)**를 소개하는 논문 발췌문입니다. 연구자들은 트랜스포머가 기계 번역 작업에서 우수한 성능을 보이며, 기존 모델보다 병렬화 가능성이 높고 훈련 시간이 훨씬 적게 소요됨을 입증합니다. 이 논문은 또한 **멀티 헤드 어텐션(Multi-Head Attention)**과 **위치 인코딩(Positional Encoding)**과 같은 모델의 구성 요소와 영어 구문 분석과 같은 다른 작업에서의 모델의 성공적인 일반화 능력을 자세히 설명합니다. 결과적으로, 트랜스포머는 WMT 2014 영어-독일어 및 영어-프랑스어 번역 작업에서 새로운 최첨단 BLEU 점수를 달성했습니다.

Доступные форматы для скачивания:

Скачать видео mp4

-

Информация по загрузке:

![[Deep Learning 101] 트랜스포머, 스텝 바이 스텝](https://ricktube.ru/thumbnail/p216tTVxues/mqdefault.jpg)

![Как внимание стало настолько эффективным [GQA/MLA/DSA]](https://ricktube.ru/thumbnail/Y-o545eYjXM/mqdefault.jpg)

![[핵심 머신러닝] Transformer](https://ricktube.ru/thumbnail/a_-YgMO0u0E/mqdefault.jpg)

![[딥러닝 기계 번역] Transformer: Attention Is All You Need (꼼꼼한 딥러닝 논문 리뷰와 코드 실습)](https://ricktube.ru/thumbnail/AA621UofTUA/mqdefault.jpg)