Grok 3 突破極限!GPU 叢集訓練的秘密:模型並行 vs. 數據並行

Автор: Yulandy Chiu的AI觀測站

Загружено: 2 мар. 2025 г.

Просмотров: 220 просмотров

🎯 立即加入線上課程

「4 小時高效入門 GenAI:學理 × Python 實作,快速上手大型語言模型 LLMs!」

https://yulandy.kaik.io/courses/genai

🔥早鳥優惠,限時1折🚀快速掌握核心技術,站上 AI 時代的最前線!

「AI線上讀書會」

https://yulandy.kaik.io/courses/aigen...

🔥早鳥優惠,限時每月只要$100!🚀 快速聚焦AI趨勢,提升 AI 思維,與專業同好交流!

👍請訂閱、按讚,支持內容創作者💡

⭐️ 內容介紹

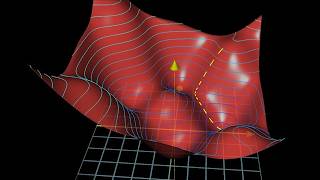

Grok 3 是當前最強大的 AI 之一,其在 Chatbot Arena 的 Elo 分數高達 1402,並在多項基準測試中表現卓越。然而,這樣的強大效能背後,離不開大規模 GPU 叢集的支持。本影片將解析 LLM 如何利用 模型並行 (Model Parallelism) 和 數據並行 (Data Parallelism) 來高效訓練,並探討 GPU 數量與 LLM 效能之間的關係。

✅ 您將能夠

了解 Grok 3 在 AI 領域的最新突破與效能表現

掌握 GPU 叢集如何加速大型語言模型 (LLM) 的訓練

理解 模型並行 和 數據並行 的原理、應用場景與優缺點

探討 GPU 數量對 LLM 效能的影響,以及影響 AI 模型能力的關鍵因素

⚡️ 關鍵字

Grok 3、GPU 叢集、模型並行 (Model Parallelism)、數據並行 (Data Parallelism)、大型語言模型 (LLM)、AI 訓練、Chatbot Arena、Elo 分數、Colossus 超級電腦、NVIDIA H100

⏰️時間戳記

0:00 Grok 3 效能解說

2:07 模型並行 (Model Parallelism)

3:33 數據並行 (Data Parallelism)

5:13 混合使用: 模型並行+數據並行

6:48 GPU 數量對 LLM 效能的影響

📊 技術詞彙清單

模型並行 (Model Parallelism):將模型的不同部分分配至多個 GPU,以突破單一設備記憶體限制

數據並行 (Data Parallelism):將數據分配至多個 GPU,每個 GPU 擁有完整的模型副本,並行訓練後同步梯度更新

Elo 分數 (Elo rating):衡量對話 AI 競爭力的指標,數值越高代表表現越佳

Colossus 超級電腦: xAI 專為訓練LLM設計的大規模 GPU 叢集,支援 Grok 3 訓練

LiveCodeBench:評估 AI 在程式設計與問題解決能力的基準測試

🔗參考文獻

xAI Colossus https://www.supermicro.com/en/feature...

xAI Grok 3 https://x.ai/blog/grok-3

AWS, Introduction to Model Parallelism https://docs.aws.amazon.com/sagemaker...

Доступные форматы для скачивания:

Скачать видео mp4

-

Информация по загрузке: