音声_Deepseek-r1 強化学習でAIが獲得した思考とひらめき

Автор: 論文紹介チャネル

Загружено: 2025-12-08

Просмотров: 2

Guo, Daya, et al. "Deepseek-r1: Incentivizing reasoning capability in llms via reinforcement learning." arXiv:2501.12948 (2025).

DeepSeek-R1:強化学習による大規模言語モデルの推論能力向上

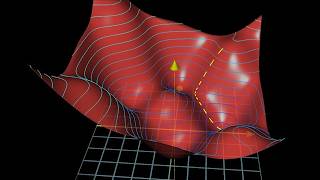

本ブリーフィングは、DeepSeek-AIが開発した新世代の推論モデル、DeepSeek-R1-ZeroおよびDeepSeek-R1に関する核心的な知見を要約したものである。最大の発見は、教師ありファインチューニング(SFT)を介さずに、純粋な強化学習(RL)のみで大規模言語モデル(LLM)の高度な推論能力を誘発できることを実証した点にある。このアプローチにより開発されたDeepSeek-R1-Zeroは、自己検証やリフレクションといった複雑な推論行動を自律的に獲得した。

DeepSeek-R1-Zeroの成功を基に、より実用的で高性能なDeepSeek-R1が開発された。このモデルは、少量の高品質データを用いた「コールドスタート」から始まり、複数段階のRLとSFTを組み合わせたパイプラインを経て訓練される。その結果、DeepSeek-R1は、数学やコーディングなどの主要な推論ベンチマークにおいて、OpenAIのo1-1217に匹敵する性能を達成した。

さらに、DeepSeek-R1で発見された推論パターンをより小規模なモデルに移植する「蒸留」の有効性も示された。この手法により、QwenやLlamaベースの複数の小規模モデルが、既存の最先端オープンソースモデルを大幅に上回る性能を獲得した。本研究は、大規模な強化学習がLLMの推論能力を飛躍的に向上させる新たな道筋を提示し、その知見をコミュニティに還元するものである。

Доступные форматы для скачивания:

Скачать видео mp4

-

Информация по загрузке:

![Как внимание стало настолько эффективным [GQA/MLA/DSA]](https://ricktube.ru/thumbnail/Y-o545eYjXM/mqdefault.jpg)